Você já parou para pensar em como as coisas acontecem nos bastidores para garantir que as operações de uma empresa funcionem sem problemas? Da automação das tarefas diárias à programação precisa das atividades, tudo isso tem um papel crucial nos ambientes corporativos. E é aí que entra o Apache Airflow, uma ferramenta open source muito usada na gestão de workflows.

Nesta edição do PET Redação, vamos falar um pouco sobre a orquestração de workflows. Além disso, vamos ver como essa prática se tornou tão usada atualmente. Ademais, vamos nos aprofundar no universo do Airflow, apresentando seus recursos e funcionalidades que o tornam uma das melhores opções para essa função.

O que é o Airflow e qual sua história?

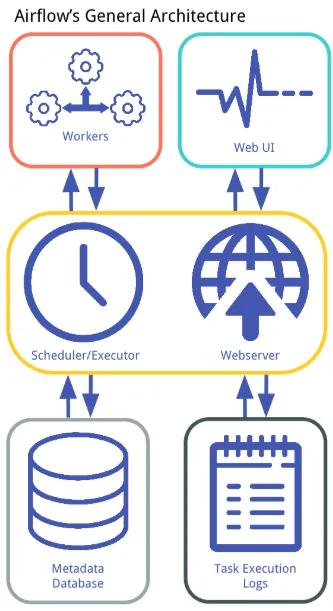

O Apache Airflow é uma plataforma de orquestração de workflows, desenvolvida para automatizar, agendar e monitorar processos complexos de dados. Surgindo como um projeto de código aberto, o Airflow foi desenvolvido originalmente pela Airbnb em 2014 para atender às demandas crescentes de gerenciamento de workflows em ambientes de dados em escala.

Como mencionado anteriormente, o Airflow teve sua origem na equipe de Engenharia de Dados da Airbnb, onde foi desenvolvido como uma solução interna para resolver desafios relacionados à execução de pipelines de dados complexos e à coordenação de tarefas agendadas. Sendo assim, já em 2015, o projeto foi lançado como open source, tornando-se parte da Apache Software Foundation.

Funcionalidades e Benefícios do Airflow:

O Airflow oferece diversas funcionalidades poderosas que o tornam uma ótima escolha para a orquestração de workflows em ambientes de dados. Aqui estão algumas das principais funcionalidades e benefícios:

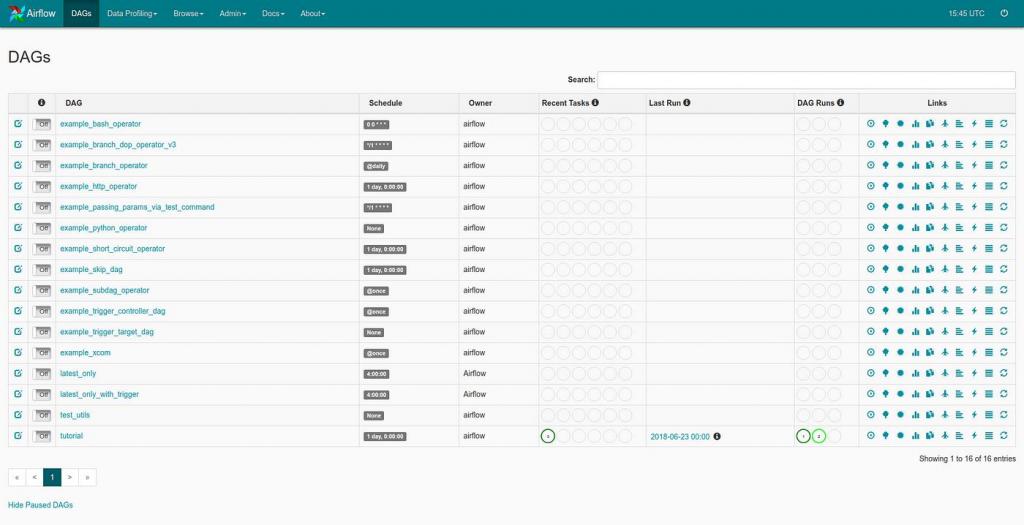

Automatização de Pipelines de Dados e Workflows: O Airflow simplifica o processo de construção e execução de pipelines de dados complexos, permitindo que os usuários definam facilmente o fluxo de trabalho desejado por meio de DAGs. Isso possibilita a automação de tarefas repetitivas e a criação de pipelines de dados confiáveis.

Uso do Python e DAGs (Directed Acyclic Graphs): Com o Airflow, os workflows são definidos de forma declarativa utilizando Python e DAGs, que consistem em várias tarefas que são executadas em ordem. Nesse sentido, essas tarefas podem ser operadores, sensores ou SubDAGs. Isso facilita a compreensão e o gerenciamento do fluxo de trabalho.

Agendamento Flexível e Gestão de Dependências: O Airflow oferece um agendador flexível que permite aos usuários especificarem quando as tarefas devem ser executadas com base em cronogramas predefinidos, gatilhos ou eventos específicos. Além disso, o Airflow gerencia automaticamente as dependências entre as tarefas, garantindo que cada etapa seja executada na ordem correta.

Monitoramento e Notificação de Execuções de Tarefas: O Airflow fornece recursos integrados de monitoramento e notificação que permitem aos usuários rastrearem o progresso e o status das execuções de tarefas em tempo real. Isso inclui logs detalhados, métricas de desempenho e alertas configuráveis, garantindo uma visibilidade completa do fluxo de trabalho. Um exemplo disso é a extensão disponível para o Slack, muito utilizada em empresas.

Escalabilidade e Extensibilidade: O Airflow é altamente escalável e pode lidar com pipelines de dados de qualquer tamanho, desde pequenas cargas de trabalho até ambientes de dados em escala empresarial. Além disso, o Airflow é altamente extensível, permitindo aos usuários estender suas funcionalidades por meio de plugins e integrações com outras ferramentas e serviços.

Casos de Uso do Airflow:

No dia a dia das empresas de tecnologia, o Airflow pode desempenhar um papel fundamental na automatização e orquestração de processos. Algumas dos principais eventos são:

CI/CD (Continuous Integration/Continuous Deployment): Empresas de tecnologia utilizam o Airflow para automatizar e orquestrar pipelines de CI/CD, garantindo a integração contínua de código e a implantação automatizada de novas versões de software.

Análise de Logs e Monitoramento de Sistemas: O Airflow é empregado para orquestrar pipelines de dados que coletam, processam e analisam logs de aplicativos e sistemas, fornecendo insights para aprimorar o desempenho e a confiabilidade dos serviços.

Exemplo: Uma empresa de tecnologia utiliza o Apache Airflow para automatizar seu processo de CI/CD, permitindo que os desenvolvedores enviem alterações de código para um repositório central. O Airflow, então, automatiza a compilação, teste e implantação do código em ambientes de produção, garantindo uma integração contínua e entrega rápida de novas funcionalidades aos usuários finais.

Desafios e Limitações:

Por mais que o Airflow seja uma ótima ferramenta, ainda assim enfrenta desafios em ambientes de grande escala e na configuração inicial de DAGs. Por exemplo, em ambientes de grande escala, o Airflow pode enfrentar desafios de escalabilidade e desempenho. Além disso, outro ponto negativo é a complexidade na Configuração e Manutenção de DAGs, pois isso pode ser complexo, especialmente em workflows com muitas dependências.

Conclusão:

O Airflow é uma ferramenta muito útil na orquestração de workflows, oferecendo diversos benefícios às pessoas que trabalham com dados, haja vista que ele simplifica a automação e a orquestração de workflows, permitindo que equipes gerenciem tarefas complexas com facilidade.

Em resumo, o Airflow desempenha um papel fundamental na automação e eficiência operacional em ambientes de dados, permitindo que equipes lidem com desafios cada vez mais complexos.

Referências:

https://airflow.apache.org/docs/

https://www.qubole.com/blog/apache-airflow-tutorial-dags-tasks-operators-sensors-hooks-xcom

https://cloud.google.com/architecture/cicd-pipeline-for-data-processing?hl=pt-br

Autor: Yuri Fonseca de Morais